Dify 完全指南(一):从零搭建开源大模型应用平台(Ollama/VLLM 本地模型接入实战)

1. 相关资源

2. 核心特性

- ✅ 多模型支持:兼容 OpenAI、Anthropic、Ollama、VLLM、Hugging Face 等数百种模型。

- ✅ 可视化 Prompt 编排:无需代码,通过界面调整 AI 行为。

- ✅ RAG 增强检索:支持知识库上传(PDF/TXT/Markdown 等),提升回答准确性。

- ✅ Agent 框架:可构建自动化 AI 工作流(如数据分析、客服机器人)。

- ✅ 灵活部署:支持 Docker 一键部署,适配本地、云端及混合环境。

3. 安装与使用(Docker Compose 部署)

参考资料

在运行安装命令之前,请确保您的机器上安装了 Docker 和 Docker Compose,安装 Docker 以及 Docker Compose 的具体步骤可以参考 Ubuntu 24.04 完整 Docker 安装指南:从零配置到实战命令大全。

3.1 部署 Dify

1 | |

值得注意的是,如果版本是 Docker Compose V1,在使用命令 docker compose 的时候,需要换成 docker-compose,例如 docker-compose up -d。

3.2 更新 Dify

1 | |

注意:

- 如果

.env.example文件有更新,请务必同步修改你本地的.env文件。 - 检查

.env文件中的所有配置项,确保它们与你的实际运行环境相匹配。你可能需要将.env.example中的新变量添加到.env文件中,并更新已更改的任何值。 - 更新后需要重启 Dify

3.3 重启 Dify

1 | |

3.4 访问 Dify

1 | |

4. 接入本地模型

接入本地模型时需要保证接入的模型服务是可用的,例如 Ollama、VLLM 等。

4.1 接入 Ollama 本地模型

参考资料

笔者实验环境为 Ubuntu24.04,宿主机启动 Ollama 服务 + Docker Compose 部署 Dify

4.1.1 步骤

- 点击

Dify平台右上角头像→设置→模型供应商,选择Ollama,点击添加模型(若Dify平台中Ollama插件未安装的话,需要先点击安装)。 - 输入

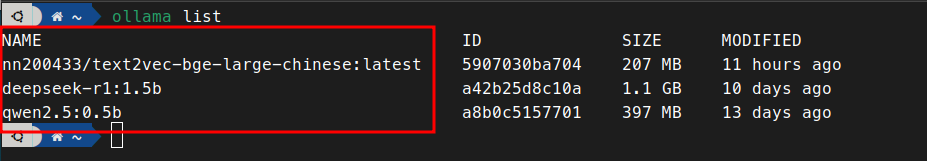

模型名称、基础URL,其他选项可使用默认设置即可,点击保存。其中:模型名称为 Ollama 服务中的模型名称,可通过ollama list获取

基础URL为 Ollama 服务地址,例如http://host.docker.internal:11434

4.1.2 常见问题

Connection refused 问题

使用官方文档中的

http://host.docker.internal:11434作为基础URL,可能会出现httpconnectionpool (host=localhost, port=11434): max retries exceeded with url:/cpi/chat (Caused by NewConnectionError ('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>: fail to establish a new connection:[Errno 111] Connection refused'))错误,此时需要直接使用宿主机的 IP 地址。解决步骤:

设置 Ollama 服务监听地址

1

2

3

4

5

6

7

8

9

10

11

12# 修改 ollama.service 文件,添加 OLLAMA_HOST 环境变量

sudo vim /etc/systemd/system/ollama.service

# 在 [Service] 下添加

Environment="OLLAMA_HOST=0.0.0.0:11434"

# 重新加载配置文件

sudo systemctl daemon-reload

sudo systemctl restart ollama

# 查看服务状态,确保 ollama 服务以 :::11434 启动

sudo netstat -tulnp | grep ollama

# 重启Dify

docker compose down

docker compose up -d获取本机 IP 地址

1

2

3

4# 获取本机IP地址,假如输出为 192.168.163.248

hostname -I | awk '{print $1}'

# 测试以本机IP是否可以查看ollama模型列表(需要将 192.168.163.248 替换为上一步实际输出的IP地址)

curl http://192.168.163.248:11434/api/tags # 应成功返回模型列表开启防火墙端口

如果仍有问题,考虑是否防火墙拦截了11434端口,需要配置防火墙规则。1

sudo ufw allow 11434/tcp && sudo ufw reload修改基础 URL 配置

修改基础 URL 配置,将http://host.docker.internal:11434修改为http://192.168.163.248:11434,再次点击保存即可。

4.2 接入 Vllm 本地模型

- 点击

Dify平台右上角头像→设置→模型供应商,选择Vllm,点击添加模型(若Dify平台中Vllm插件未安装的话,需要先点击“安装”)。 - 输入

模型名称、API endpoint URL,其他选项可使用默认设置即可,点击保存。其中:模型名称为 Vllm 服务启动的模型名称API endpoint URL为 Vllm 服务地址,例如http://192.168.163.248:8000/v1

5. 进阶应用场景

🔹 知识库问答:上传企业文档,构建智能客服。

🔹 AI 工作流:结合 Agent 实现自动化任务(如邮件撰写+数据分析)。

🔹 私有化部署:企业级数据安全,完全本地运行。

6. 总结

Dify 是当前最易用的开源 LLM 应用平台之一,适合快速搭建 AI 应用。本文详细介绍了 Docker 部署、Ollama/VLLM 本地模型接入 及常见问题排查,帮助开发者高效落地 AI 项目。